Ingestão eficiente de dados em sua lakehouse

Dê o primeiro passo para desbloquear a inovação com inteligência de dados.

Desbloqueie valor dos seus dados em apenas alguns passos fáceis

Conectores de dados integrados estão disponíveis para aplicativos empresariais populares, fontes de arquivos e bancos de dados.Capacidades robustas de ingestão para fontes de dados populares

Trazer todos os seus dados para a Plataforma de Inteligência de Dados é o primeiro passo para extrair valor e ajudar a resolver os problemas de dados mais desafiadores da sua organização.A interface de usuário sem código (UI) ou uma API simples capacita os profissionais de dados a se autoatenderem, economizando horas de programação.

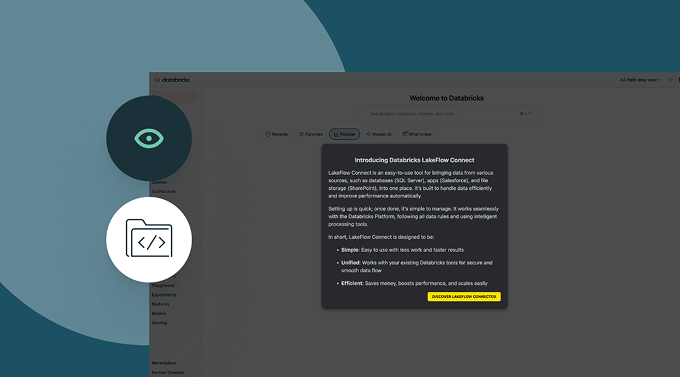

Faça um tour pela interface do usuário do Lakeflow Connect

Ingestão de dados com Databricks

Resolvendo problemas de clientes em uma variedade de indústrias

Explore demonstrações de ingestão de dados

O preço baseado no uso ajuda a controlar despesas

Pague apenas pelos produtos que usar por segundo.Descubra mais

Explore outras ofertas integradas e inteligentes na plataforma de inteligência de dados.Jobs do Lakeflow

Capacite as equipes para automatizar e orquestrar melhor qualquer fluxo de trabalho de ETL, analítica e IA com observabilidade detalhada, alta confiabilidade e amplo suporte a tipos de tarefas.

Pipelines Declarativos do LakeFlow

Simplifique o ETL em lotes e transmissão com qualidade de dados automatizada, captura de dados de alterações (CDC), ingestão de dados, transformações e governança unificada.

Unity Catalog

Governe sem esforço todos os seus ativos de dados com a única solução de governança unificada e aberta do setor para dados e AI, integrada à Databricks Data Intelligence Platform.

Delta Lake

Unifique os dados em seu lakehouse, em todos os formatos e tipos, para todas as suas cargas de trabalho de analytics e AI.

Introdução

Explore a documentação de ingestão de dados

Ingestão de dados de várias fontes, através de nuvens e via Lakeflow Connect.

Tour pelo Lakeflow Connect

Lakeflow Connect agora está geralmente disponível para Salesforce, Workday e SQL Server.

Para acesso prévio a outros conectores, por favor, entre em contato com a sua equipe de conta Databricks.

Perguntas frequentes sobre ingestão de dados

Pronto para se tornar uma empresa de dados + AI?

Dê os primeiros passos na transformação dos seus dados